2024. 2. 2. 19:10ㆍ부트캠프

Linear Regression

feature 와 target 사이의 관계를 선형 모델로 찾자

given X,y find f

f를 어떻게 정의하느냐 -> 모델을 어떤걸 사용하느냐

지금 있는 데이터를 linear한 형태로 보고싶다.

X,y 가 linear한 관계 x -> 해결 : 모델을 바꿔야함

X,y 가 '이상적'으로는 linear 였는데 관측과정에서 오염 -> 처음엔 이걸로 먼저 출발

즉 y != w1x1 + w2x2 + b

w1,w2,b를 조절해서 linear한 형태로 나타내야함. L이 최소가 되는 (0에 가까워지는). L 은 (실제값-예측값)^2을 다 더한것 . Loss function

분류(classification)와 회귀(regression) 차이 묻는 질문도 굉장히 많이나옴

분류(classification)

svm

헤비하다 이정도 연산 할 바엔 딥러닝함.

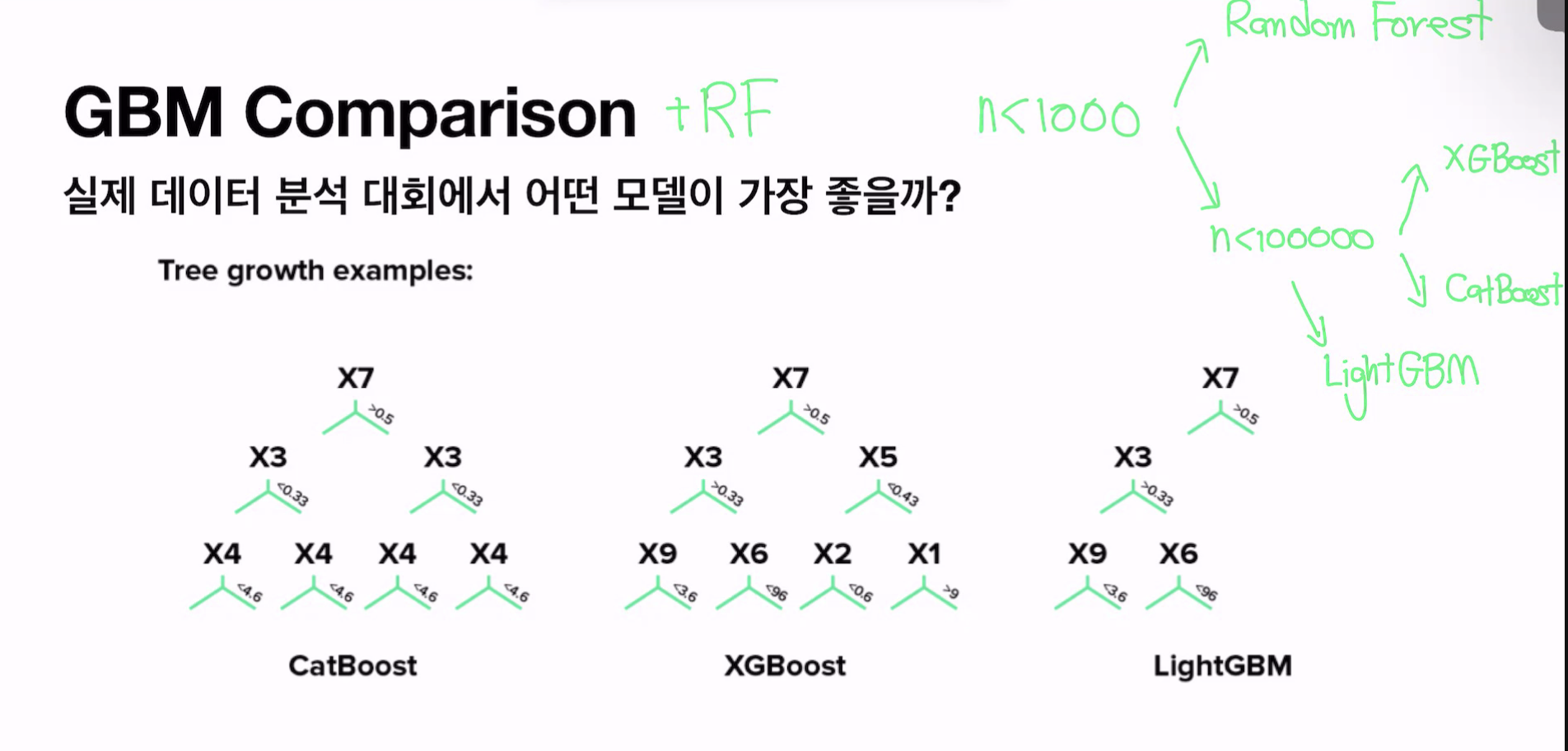

데이터셋의 크기가 작을때(1000 이하) 사용해볼 수 있다

훨씬 좋은 모델이 많이 나옴.

linear classifier이기 때문에, non-linear한 문제를 풀기 위해선 kernel trick을 사용해야한다.

non-linear seperable + regulariztion method

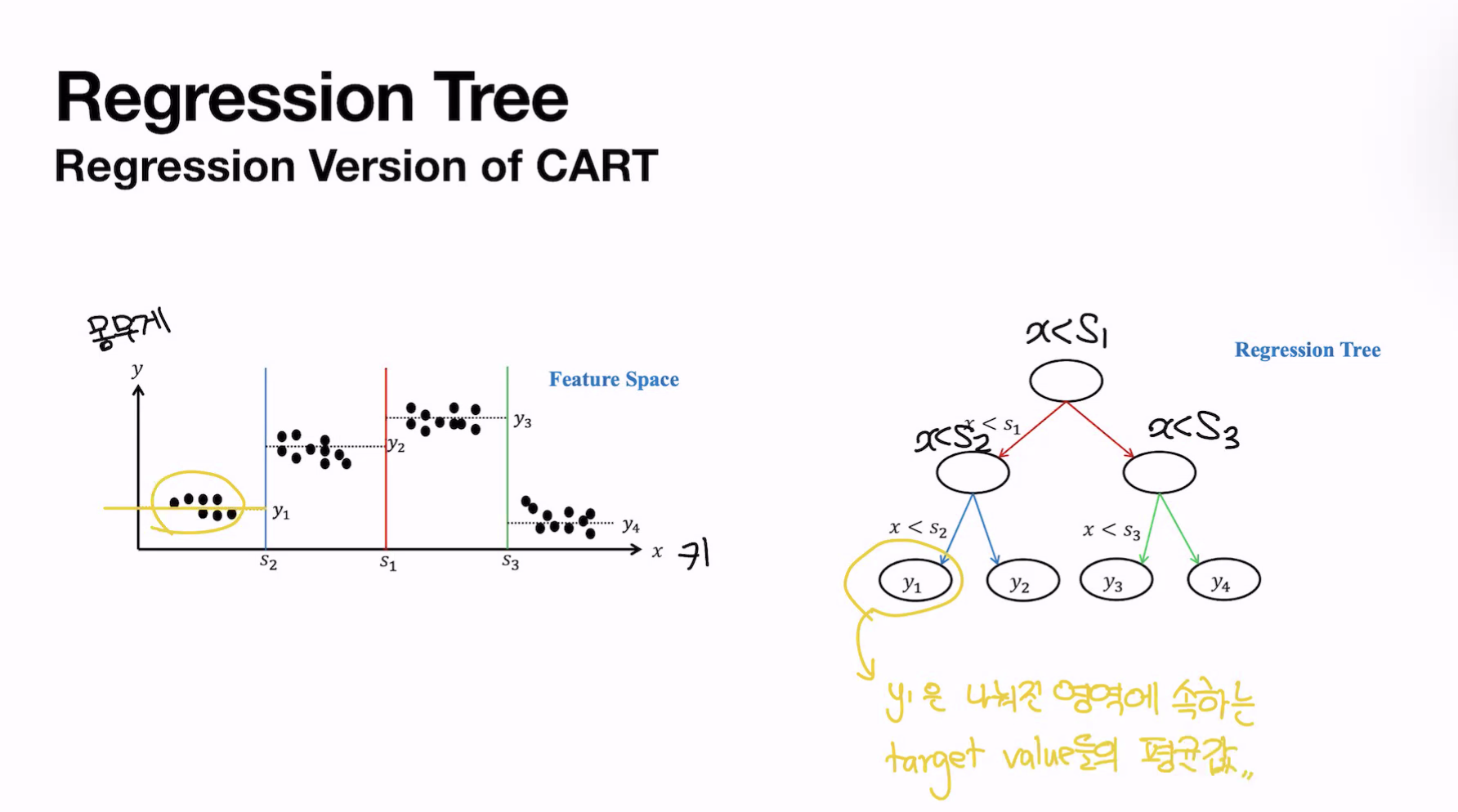

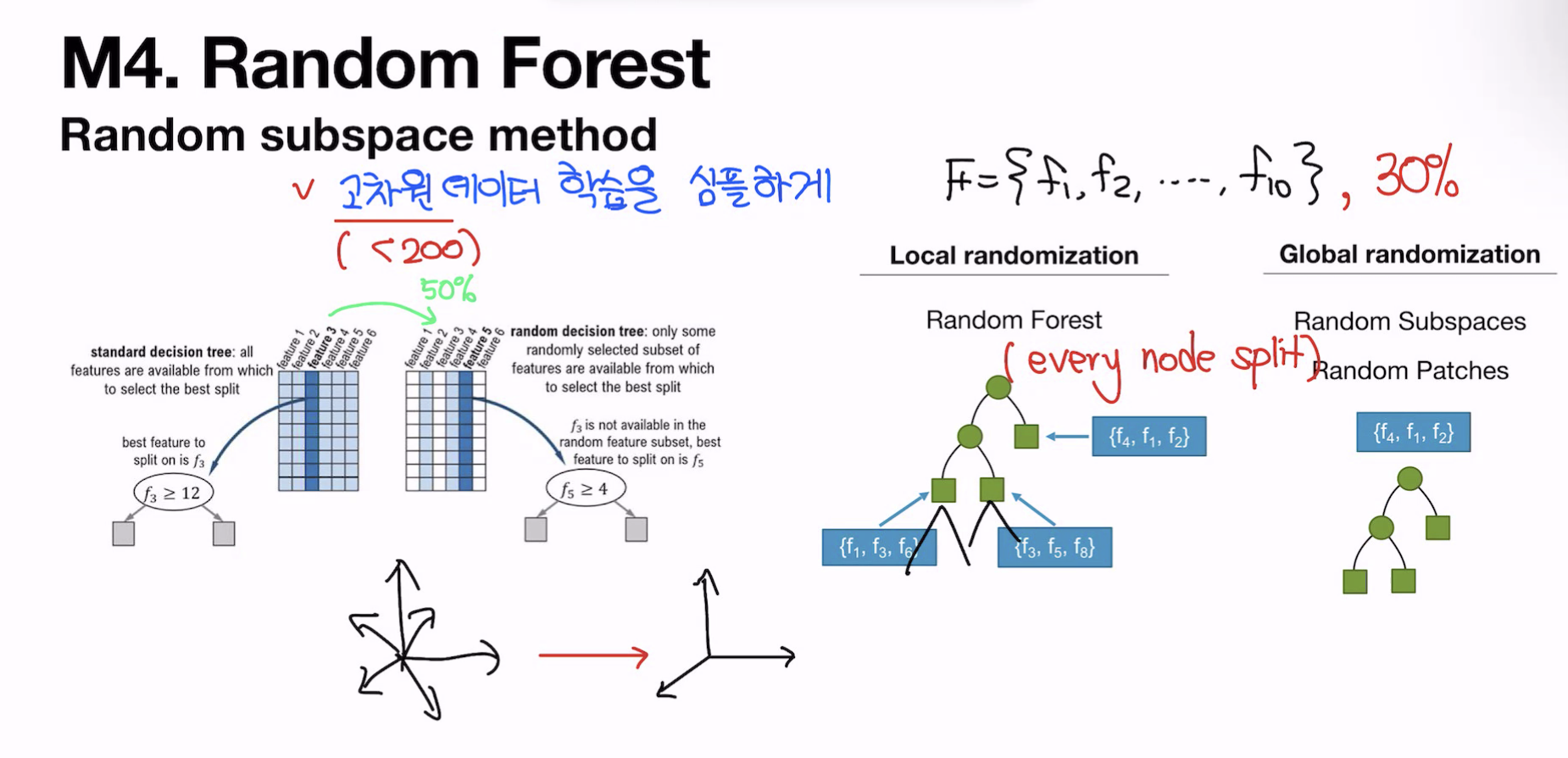

CART ( classification and regression tree)

회귀모델은 평균값으로 예측

classification tree 에서 child node간의 정보차이가 클수록 좋음

존재하는 모든 기준에 대해서 gini index를 최소로 하는 기준을 root에 선택!

bias 를 줄이는 방법 ( regularization)

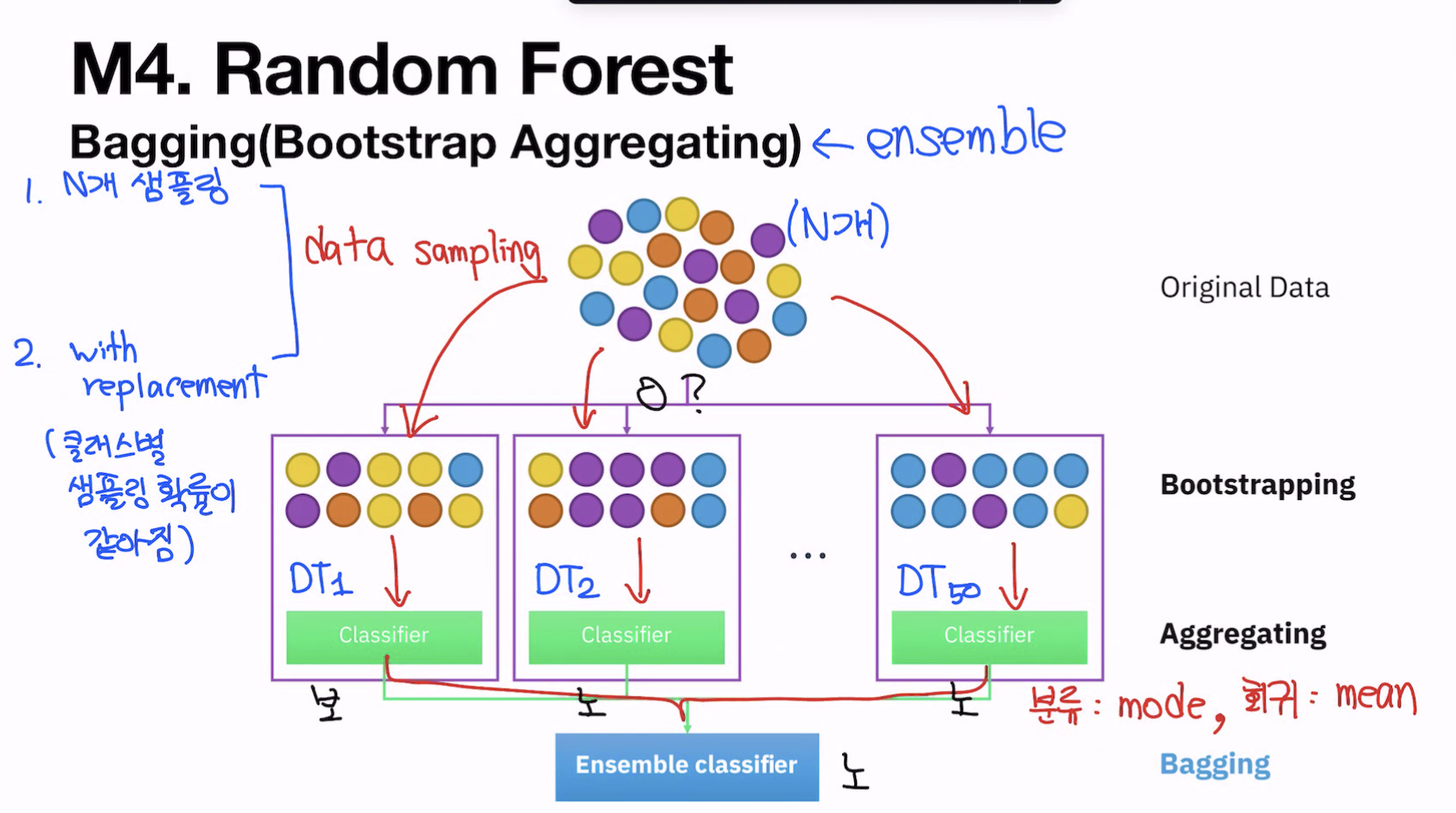

variance 를 올려주는 방법( ensemble)

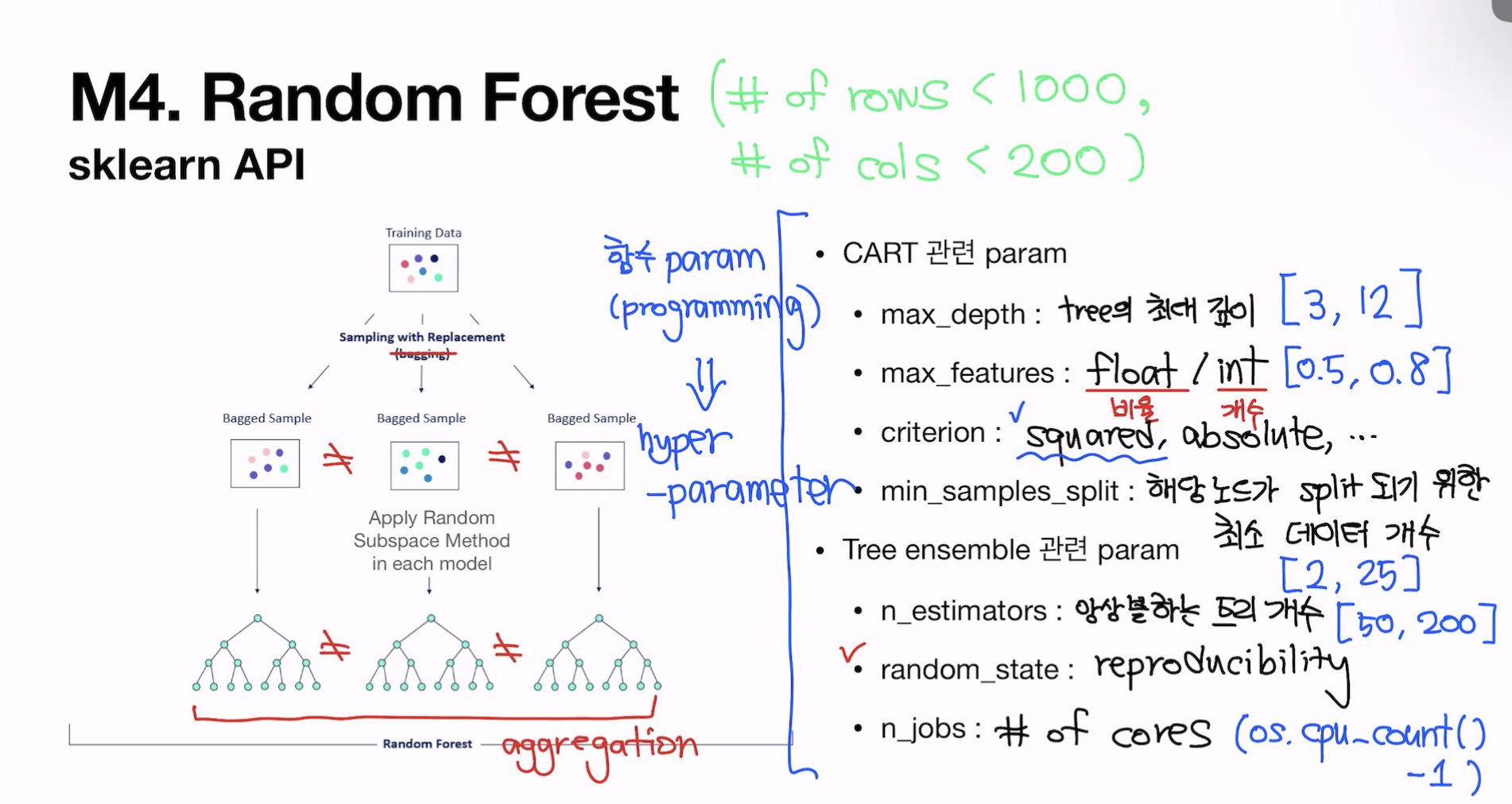

n_jobs -1은 풀파워로 다 돌릴때.

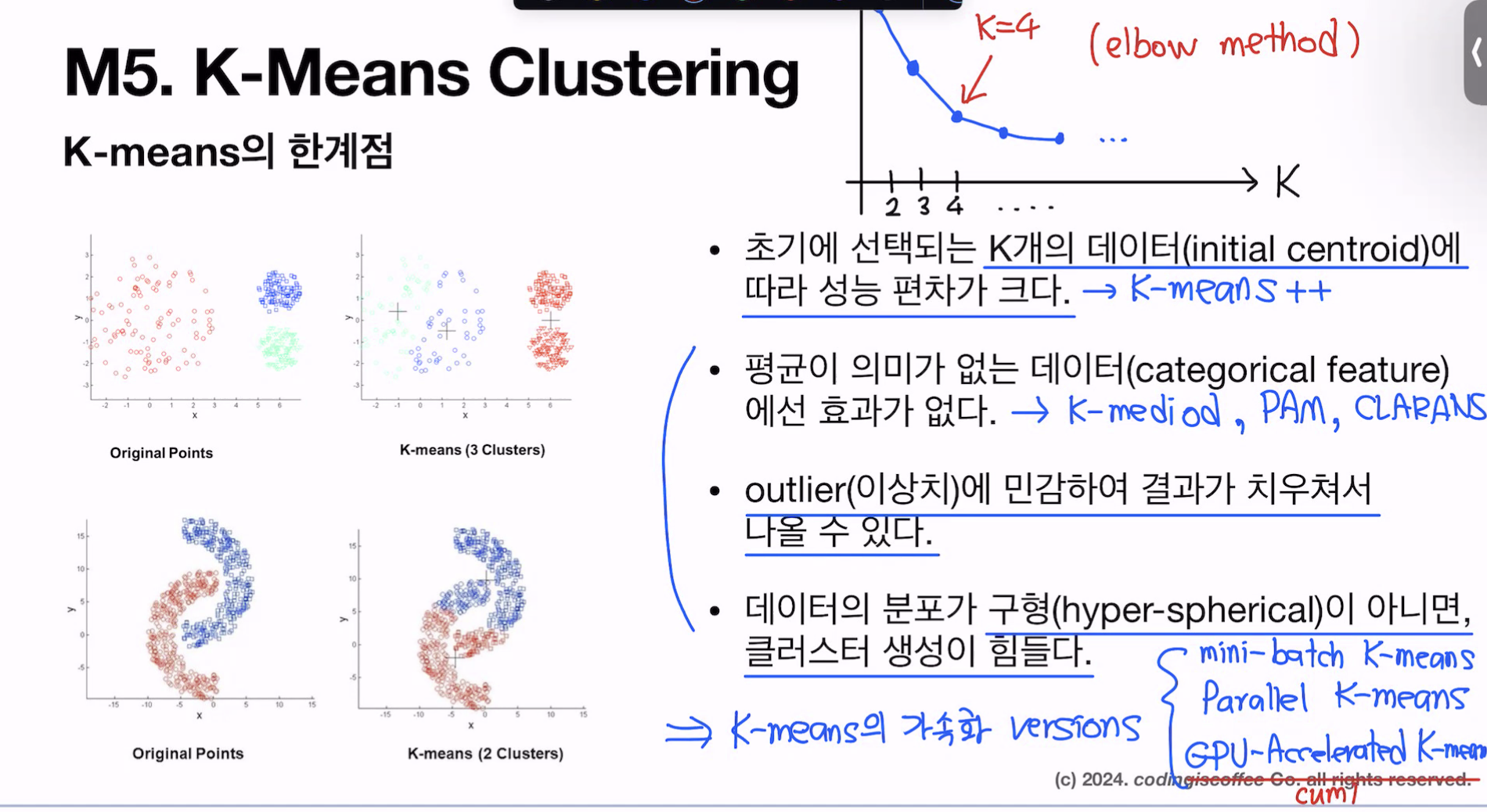

clustering(unsupervised learning)

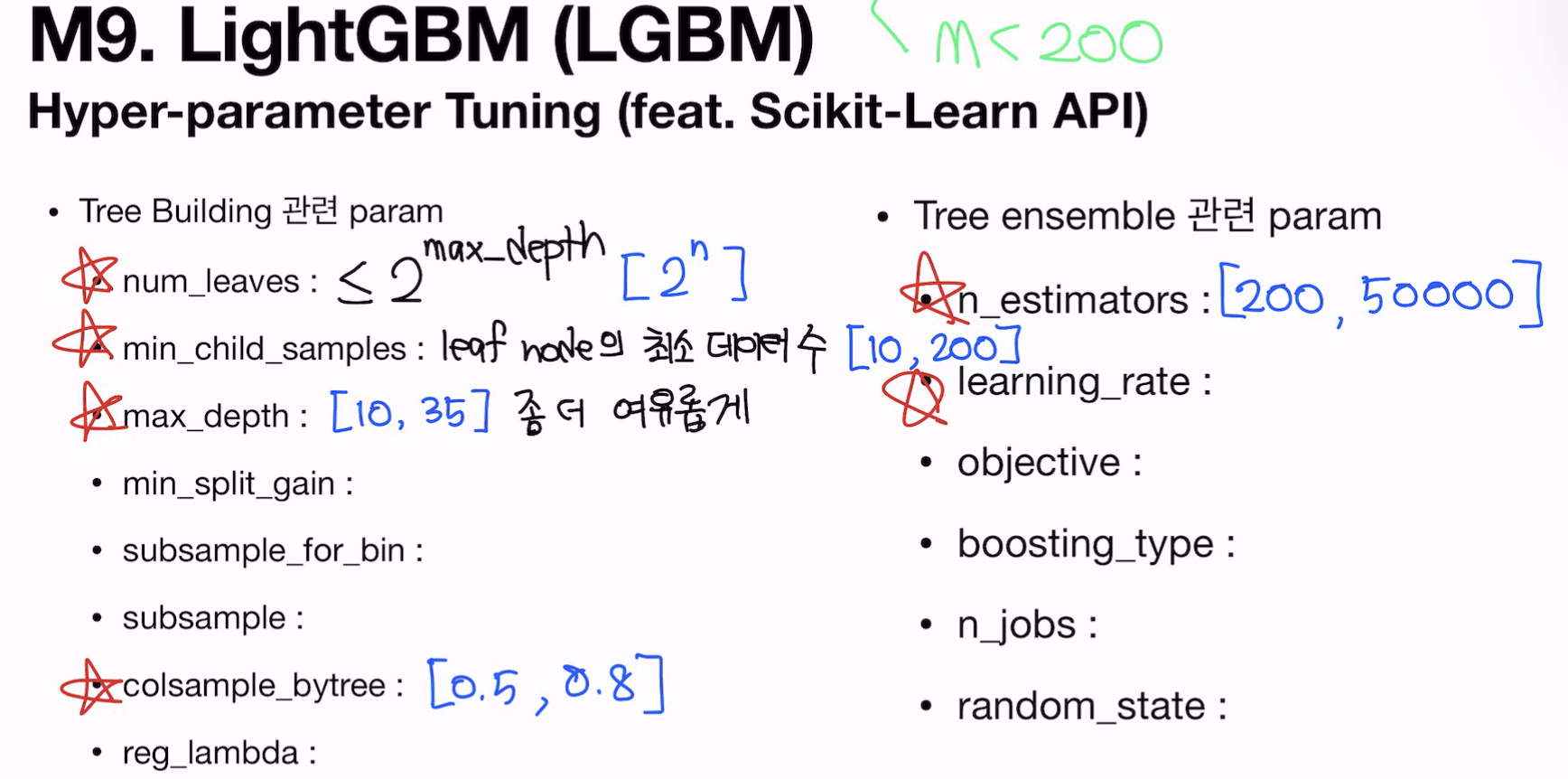

max_depth를 설정하고 leaves를 조절.

LGBM은 좋은거만 선택해서 한쪽으로만 트리가 성장할 수있기때문에 .

max_depth가 10 이면 최대 노드 개수 2^10. leaves는 이 최대 노드 개수를 넘을 수가 없음. 하이퍼 파라미터는 제한을 거는거기때문에 leaves가 max_depth보다 낮아야 의미가있음. 이거보다 크면 warning뜸. 의미가없어서.

colsample_bytree 만 가능

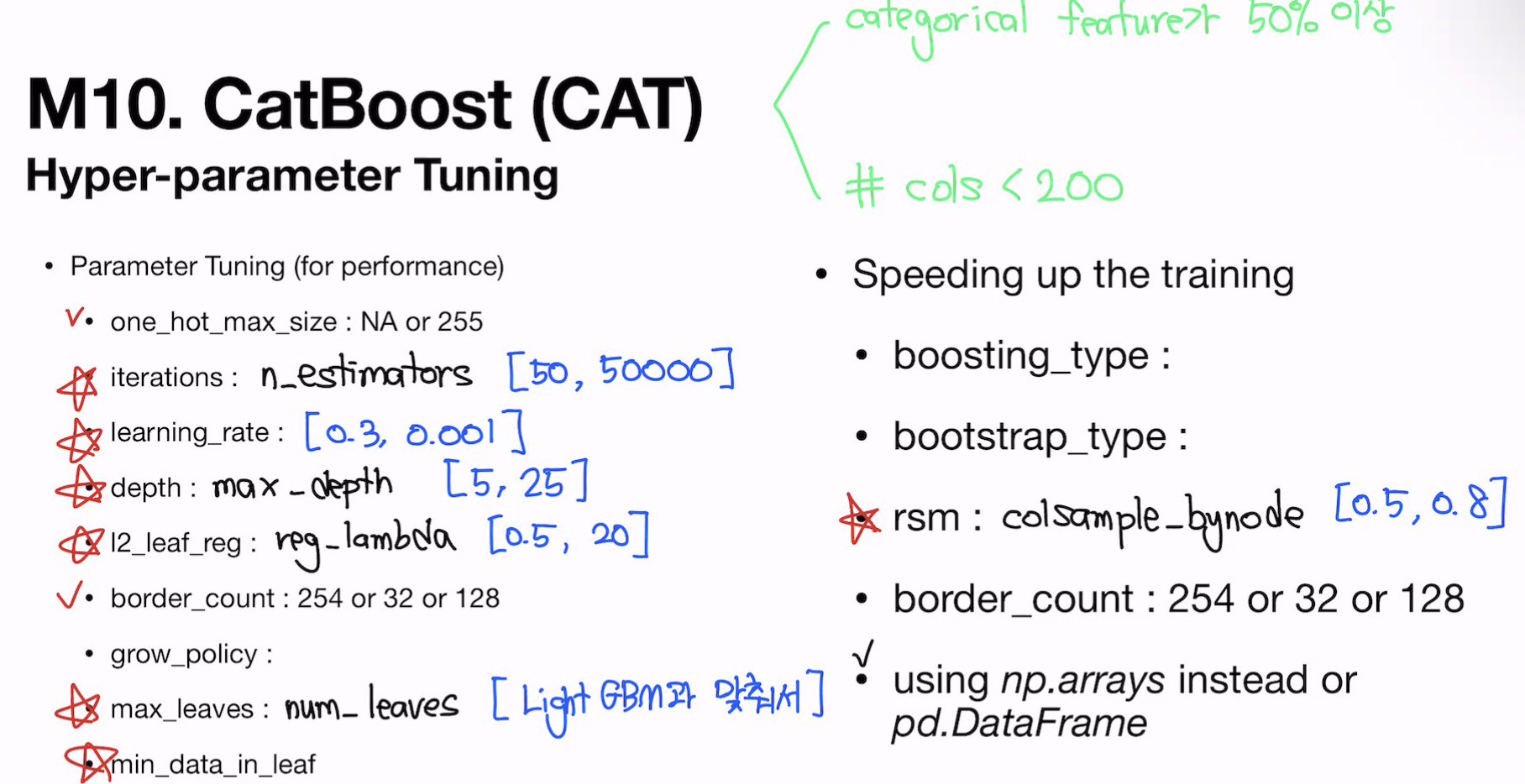

catboost -> categorical feature가 50% 이상, column<200

AutoML : pycaret, autogluon

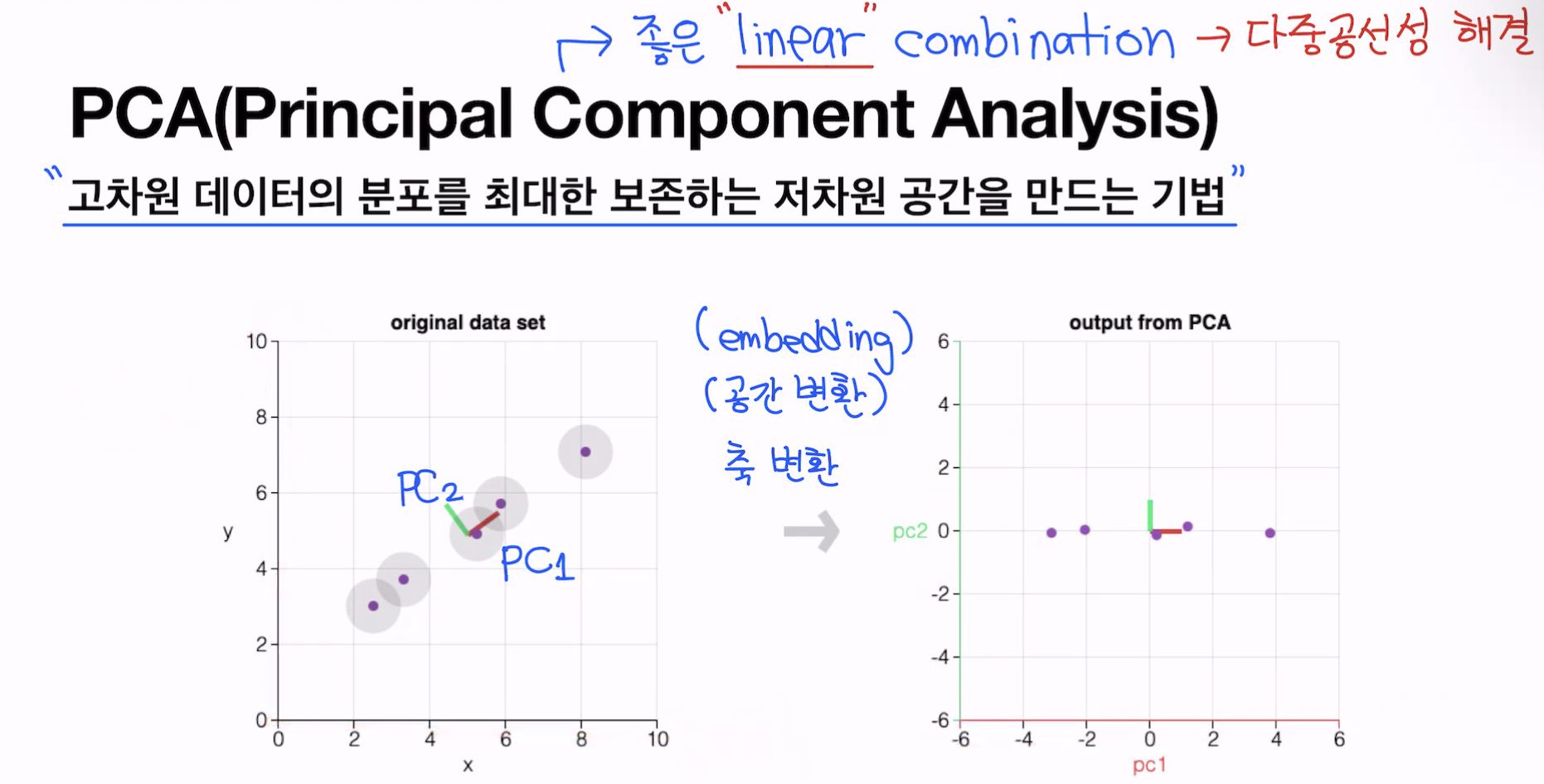

데이터의 방향대로 차원을 축소

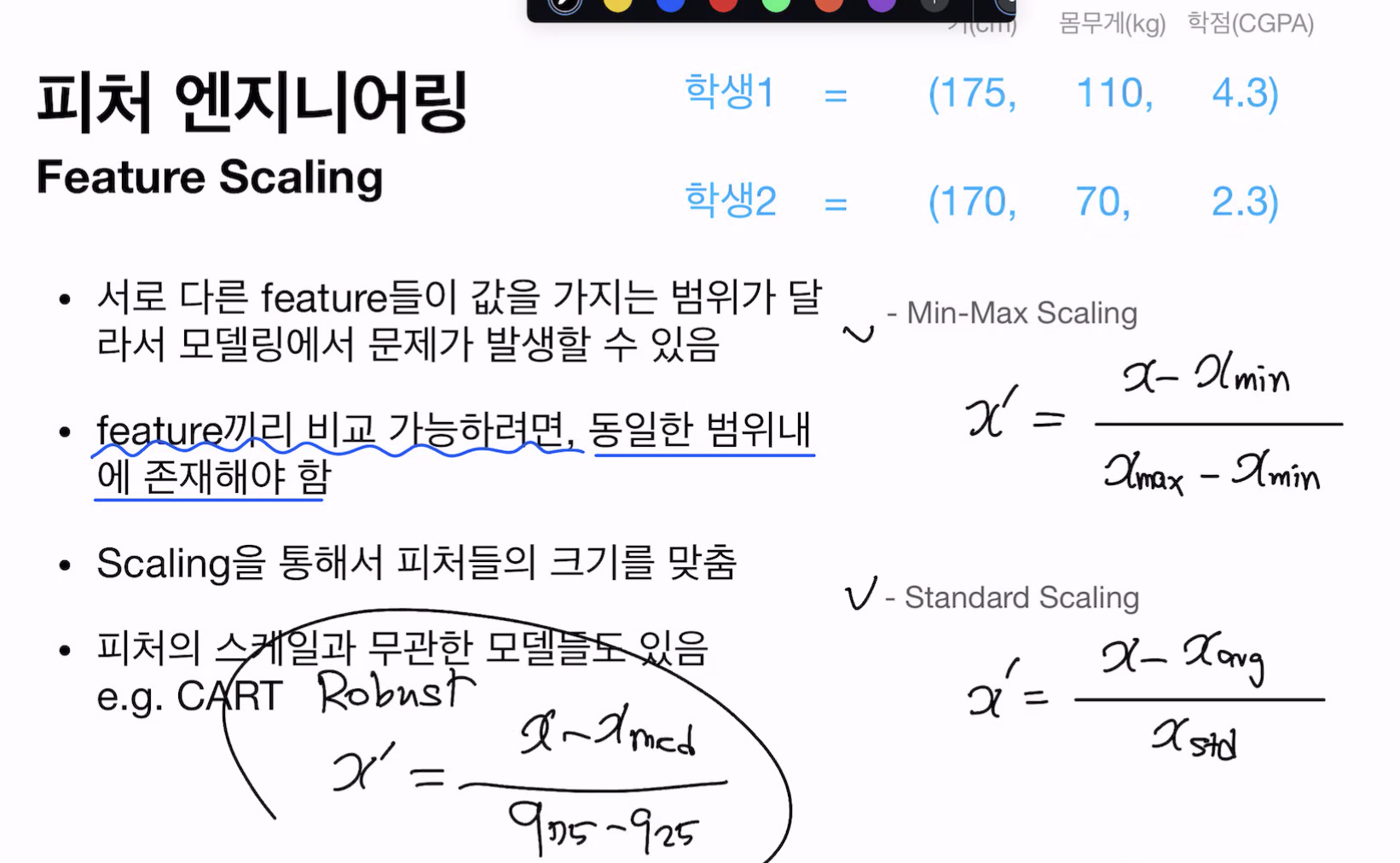

robust scaler -> outlier에 덜 민감, outlier 가 있는 데이터에서는 평균과 표준편차는 크게 영향을 받을 수 있지만, 중앙값과 사분위수는 영향을 덜 받음

min-max 는 범위가 [0,1]

standard 는 평균이 0 , 분산이 1 , 음수값 가능

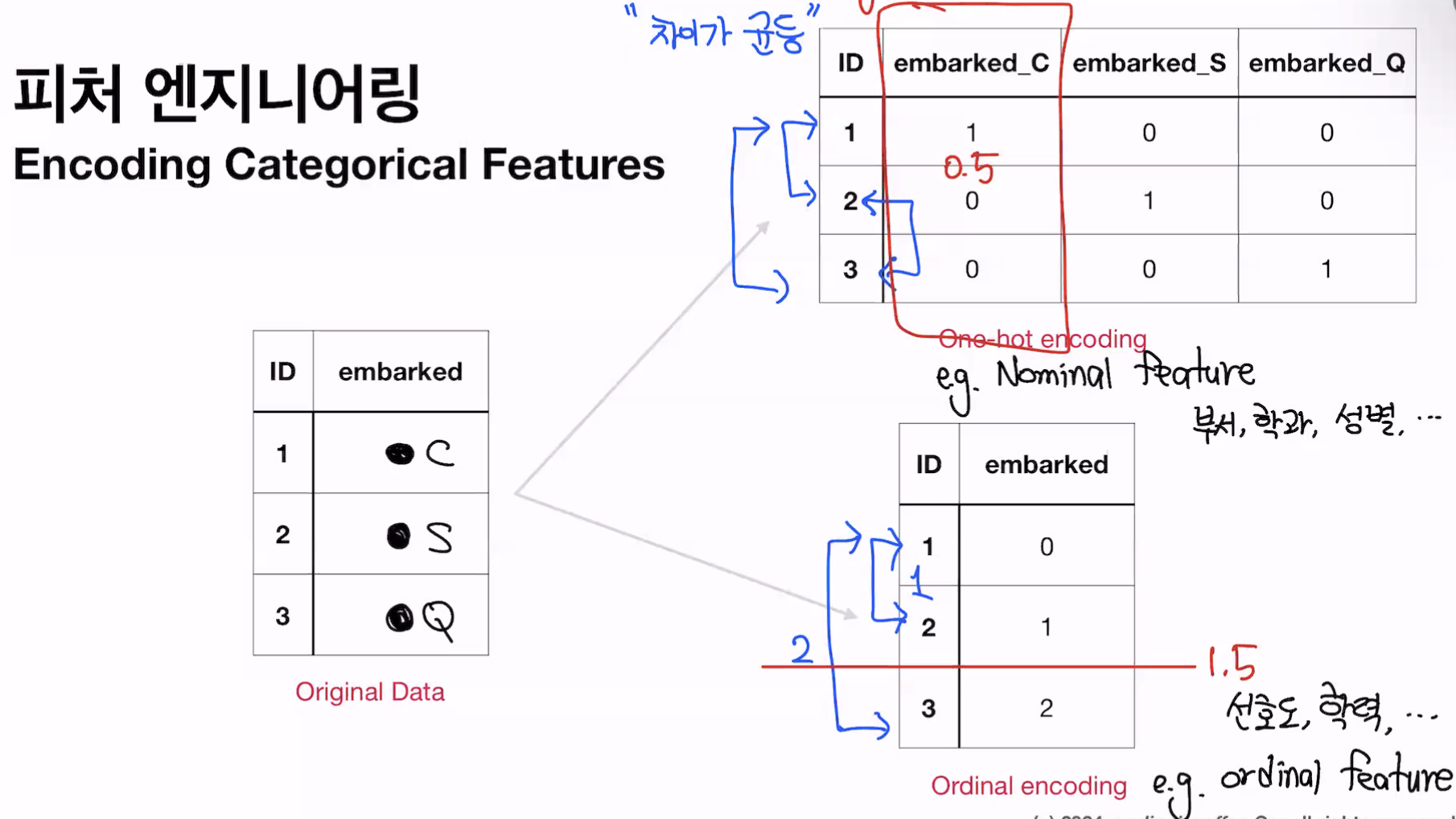

범주형 데이터 - 명목형(Norminal), 순서형(Ordinal)

Ordinal feature ->Categorical feature(범주형 특성)에 대한 순서형 코딩이라고 하며, 각 범주들을 특성으로 변경하지 않고, 그 안에서 1,2,3 등의 숫자로 변경하는 방법이다. 범주가 너무 많아 one hot encoding을 하기 애매한 상황에서 이용하기 좋은 인코딩 방법이다. 또한 트리모델은 중요한 feature가 상위 노드를 점하여 분할을 하게 되는데, one hot encoding을 한 특성은 뽑히기에 불리한 상태가 되므로 대안으로 Ordinal Encoding을 한다.

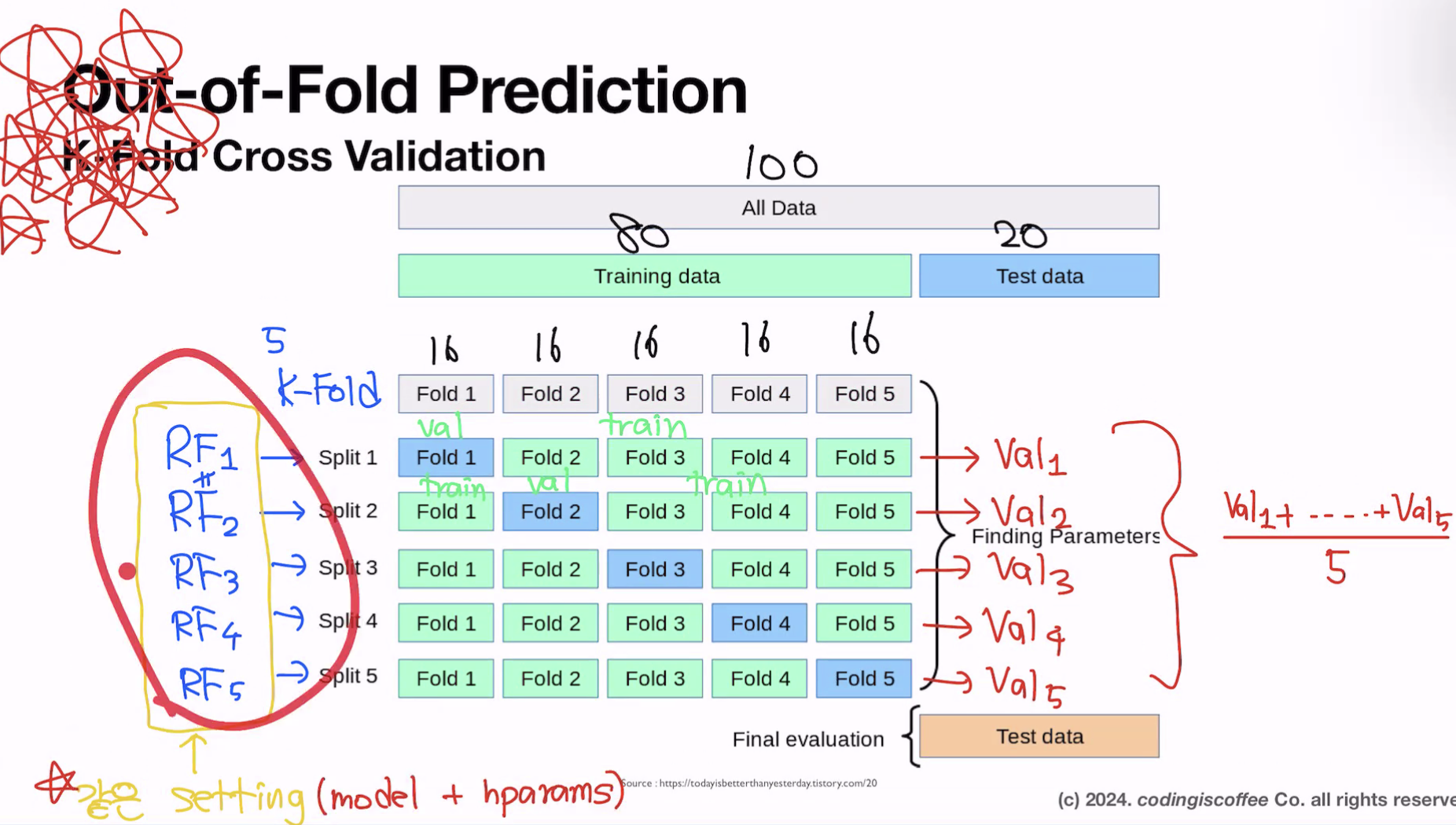

k-fold

데이터가 늘어나면 k 를 키우는게 좋은 편 -> 한 fold 가 validation data인데 이 크기가 커지는 거기 때문. 하지만 시간이 오래걸림. 모델사이즈에 depend

모델사이즈가 작으면 k를 키우고, 모델 사이즈가 크면 k

'부트캠프' 카테고리의 다른 글

| 첫번째 그룹스터디 세미나 및 회고 (0) | 2024.03.15 |

|---|---|

| ML project : Home Credit - Credit Risk Model Stability (0) | 2024.02.22 |

| 통계 (1) | 2024.01.24 |

| EDA (1) | 2024.01.12 |

| 3회차 학습일지 (0) | 2023.12.29 |